Kaip sukurti interneto svetainės robots.txt failą

Kaip sukurti interneto svetainės robots.txt failą – „Robots.txt“ yra teksto failas, kurį žiniatinklio valdytojai kuria tam, kad žiniatinklio robotams (paprastai paieškos robotams) nurodytų, kaip tikrinti savo internetinės svetainės puslapius. Failas „robots.txt“ yra robotų išskyrimo protokolo (REP), žiniatinklio standartų grupės, reguliuojančios, kaip robotai tikrina žiniatinklį, prieina ir indeksuoja turinį, ir teikia tą turinį vartotojams. REP taip pat apima tokias direktyvas kaip meta robotai, taip pat svetainės puslapio, pakatalogio ar visos svetainės instrukcijas, kaip paieškos sistemos turėtų elgtis su nuorodomis (pvz., „Sekti“ ar „nofollow“).

Kaip sukurti interneto svetainės robots.txt failą

Praktiškai failai robots.txt nurodo, ar tam tikri vartotojo agentai (žiniatinklio tikrinimo programinė įranga) gali ar negali tikrinti svetainės dalių. Šios tikrinimo instrukcijos nurodomos „neleidžiant“ arba „leidžiant“ tam tikrų (arba visų) vartotojo agentų elgesį.

Pagrindinis formatas:

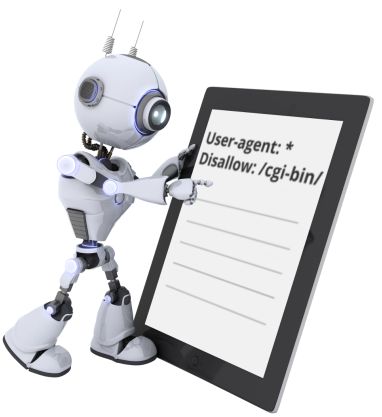

Vartotojo agentas: [vartotojo agento vardas] Neleisti: [URL eilutės negalima tikrinti]

User-agent: [user-agent name]Disallow: [URL string not to be crawled]

Kartu šios dvi eilutės laikomos užbaigtu robots.txt failu, nors viename roboto faile gali būti kelios vartotojo agentų ir direktyvų eilutės (ty neleidžia, leidžia, tikrina ir vėluoja).

Robots.txt faile kiekvienas vartotojo agento direktyvų rinkinys rodomas kaip atskiras rinkinys , atskirtas eilutės pertrauka.

Internetinės svetainės robots.txt faile, kuriame yra kelios „user-agent“ direktyvos, kiekviena neleidžiama arba leidžiama taisyklė taikoma tik tiems vartotojo agentams, kurie nurodyti tame konkrečiame eilutės pertraukimo rinkinyje. Jei faile yra taisyklė, taikoma daugiau nei vienam vartotojo agentui, tikrintuvas atkreips dėmesį tik į konkrečiausią instrukcijų grupę (ir vykdys direktyvas) .

Kaip veikia interneto svetainės robots.txt failas

Paieškos sistemos turi du pagrindinius darbus:

- Tikrinimas internete siekiant atrasti turinį;

- Indeksuoti tą turinį, kad jį būtų galima pateikti informacijos ieškantiems ieškotojams.

Norėdamos tikrinti internetines svetaines, paieškos sistemos vadovaujasi nuorodomis, kad patektų iš vienos svetainės į kitą – galų gale, tikrindamos daugybę milijardų nuorodų ir svetainių. Šis nuskaitymo elgesys kartais žinomas kaip „voras“.

Nuvykęs į interneto svetainę, bet prieš ją persiuntęs, paieškos tikrintuvas ieškos robots.txt failo. Jei rado, tikrintuvas pirmiausia perskaitys tą failą prieš tikrindamas svetainės puslapį. Kadangi robots.txt faile yra informacijos apie tai, kaip paieškos variklis turėtų tikrinti, jame rasta informacija nurodys tolesnius tikrinimo veiksmus šioje konkrečioje svetainėje. Jei robots.txt failas negali būti jokių direktyvų, kad Neleisti vartotojui agento veiklą (arba jei svetainėje nėra robots.txt failo), bus pradėta nuskaityti kitą informaciją svetainėje.

Kiti greiti robotai.txt turi žinoti:

(išsamiau aptarta toliau)

- Kad būtų galima rasti frobots.txt failą, jis turi būti įdėtas į svetainės aukščiausio lygio katalogą.

- Robots.txt skiria didžiosios ir mažosios raidės: failas turi būti pavadintas „robots.txt“ (ne „Robots.txt“, „robots.TXT“ ar kt.).

- Kai kurie vartotojų agentai (robotai) gali pasirinkti nepaisyti robots.txt failo. Tai ypač būdinga kenksmingesniems robotams, pvz., Kenkėjiškų programų robotams ar el. Pašto adresų grandikliams.

- Failas /robots.txt yra viešai prieinamas: tiesiog pridėkite /robots.txt prie bet kurio šakninio domeno pabaigos, kad pamatytumėte tos svetainės nurodymus (jei toje svetainėje yra robots.txt failas!). Tai reiškia, kad visi gali matyti, kokius puslapius jūs rodote ar nenorite tikrinti, todėl nenaudokite jų asmeninei vartotojo informacijai slėpti.

- Kiekvienas šakninio domeno padomenis naudoja atskirus robots.txt failus. Tai reiškia, kad tiek blog.example.com, tiek example.com turėtų turėti savo robots.txt failus (adresu blog.example.com/robots.txt ir example.com/robots.txt).

Techninė robots.txt sintaksė

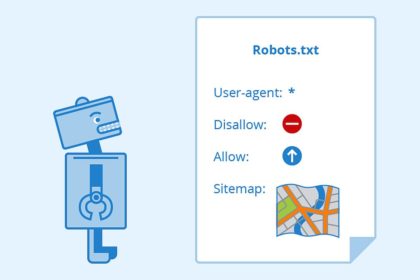

„Robots.txt“ sintaksę galima laikyti „robots.txt“ failų „kalba“. Yra penki įprasti terminai, su kuriais tikriausiai susiduriate robotų faile. Jie įtraukia:

- „User-agent“: konkretus žiniatinklio tikrintuvas, kuriam pateikiate tikrinimo instrukcijas (dažniausiai paieškos variklis).

- Neleisti – Disallow: komanda naudojama liepti vartotojo agentui netikrinti konkretaus URL. Kiekvienam URL leidžiama tik viena eilutė „Neleisti:“.

- Leisti – Allow (taikoma tik „Googlebot“): komanda, nurodanti „Googlebot“, kad ji gali pasiekti puslapį ar poaplankį, net jei jo pirminis puslapis ar poaplankis gali būti neleidžiamas.

- Tikrinimo uždelsimas – Crawl-delay: kiek sekundžių tikrintuvas turėtų palaukti, kol įkels ir tikrins puslapio turinį. Atminkite, kad „Googlebot“ nepripažįsta šios komandos, tačiau tikrinimo greitį galima nustatyti „Google Search Console“.

- Svetainės schema – Sitemap: naudojama iškviesti visų su šiuo URL susietų XML svetainių schemų vietą. Atminkite, kad šią komandą palaiko tik „Google“, „Ask“, „Bing“ ir „Yahoo“.

Rašto derinimas

Kalbant apie faktinius URL, kuriuos reikia užblokuoti ar leisti, robots.txt failai gali būti gana sudėtingi, nes jie leidžia naudoti šablonų atitikimą, kad apimtų įvairias galimas URL parinktis. „Google“ ir „Bing“ gerbia du įprastus posakius , kuriuos galima naudoti norint nustatyti puslapius ar poaplankius, kurių SEO nori pašalinti. Šie du simboliai yra žvaigždutė (*) ir dolerio ženklas ($).

- * yra pakaitos simbolis, žymintis bet kokią simbolių seką

- $ sutampa su URL pabaiga

Kur interneto svetainėje yra robots.txt failas?

Kai tik jie ateina į svetainę, paieškos sistemos ir kiti žiniatinklio tikrinimo robotai (pvz., „ Facebook“ tikrintuvas , „Facebot“) žino, kad reikia ieškoti failo robots.txt. Bet jie ieškos to failo tik vienoje konkrečioje vietoje: pagrindiniame kataloge, paprastai jūsų šakniniame domene ar pagrindiniame puslapyje.

Kodėl jums reikia robots.txt?

Robots.txt failai kontroliuoja tikrintuvo prieigą prie tam tikrų jūsų svetainės sričių. Nors tai gali būti labai pavojinga, jei netyčia neleisite „Googlebot“ tikrinti visos svetainės (!!), yra atvejų, kai robots.txt failas gali būti labai naudingas.

Kai kurie įprasto naudojimo atvejai:

- Užkirsti kelią pasikartojančio turinio rodymui SERP (atkreipkite dėmesį, kad meta robotai dažnai yra geresnis pasirinkimas)

- Išlaikyti visas svetainės skiltis privačias (pvz., Inžinierių komandos sustojimo svetainę)

- Neleisti vidinių paieškos rezultatų puslapių rodyti viešame SERP

- Svetainės žemėlapio (-ių) vietos nurodymas

- Neleisti paieškos sistemoms indeksuoti tam tikrų failų jūsų svetainėje (vaizdų, PDF ir kt.)

- Nurodykite tikrinimo delsą, kad jūsų serveriai nebūtų perkrauti, kai tikrintuvai vienu metu įkelia kelis turinio elementus

Jei jūsų svetainėje nėra sričių, į kurias norite kontroliuoti prieigą prie vartotojo agento, gali būti, kad robots.txt failo visai nereikia.

Tikrinama, ar turite failą robots.txt

Nežinote, ar turite failą robots.txt? Tiesiog įveskite šakninį domeną, tada pridėkite /robots.txt prie URL pabaigos. Pavyzdžiui, mūsų robotų failas yra adresu https://my-worlds.com/robots.txt

Kaip sukurti failą robots.txt

Jei radote, kad neturite robots.txt failo arba norite pakeisti savo failą, jo sukūrimas yra paprastas procesas. Šiame Google straipsnyje aprašomas failo „robots.txt“ kūrimo procesas ir šis įrankis leidžia išbandyti, ar failas nustatytas tinkamai.

Ieškote praktikos kuriant robotų failus? Šiame tinklaraščio įraše pateikiami keli interaktyvūs pavyzdžiai.

SEO geriausios praktikos pavyzdžiai

- Įsitikinkite, kad neužblokuojate norimo tikrinti svetainės turinio ar skilčių.

- Robots.txt užblokuotų puslapių nuorodos nebus stebimos. Tai reiškia: 1.) Susieti šaltiniai nebus tikrinami ir gali būti neindeksuoti, nebent jie taip pat bus susieti iš kitų paieškos varikliui prieinamų puslapių (ty puslapių, kurie nėra užblokuoti per robots.txt, meta robotus ar kt.). 2.) Jokio nuorodos kapitalo negalima perkelti iš užblokuoto puslapio į nuorodos paskirties vietą. Jei turite puslapių, kuriems norite perduoti nuosavo kapitalo, naudokite kitą blokavimo mechanizmą, išskyrus robots.txt.

- Nenaudokite robots.txt, kad neskelbtini duomenys (pvz., Privataus vartotojo informacija) nebūtų rodomi SERP rezultatuose. Kiti puslapiai gali tiesiogiai susieti su puslapiu, kuriame yra privati informacija (taip apeinant robots.txt direktyvas jūsų šakniniame domene ar pagrindiniame puslapyje), jis vis tiek gali būti indeksuojamas. Jei norite užblokuoti savo puslapį paieškos rezultatuose, naudokite kitą metodą, pvz., Apsaugą slaptažodžiu arba „noindex“ meta direktyvą .

- Kai kuriose paieškos sistemose yra keli vartotojų agentai. Pavyzdžiui, „Google“ naudoja „Googlebot“ natūraliai paieškai, o „Googlebot-Image“ – vaizdų paieškai. Dauguma vartotojo agentų iš to paties paieškos variklio laikosi tų pačių taisyklių, todėl nereikia nurodyti kiekvieno paieškos variklio kelių tikrintuvų direktyvų, tačiau turėdami galimybę tai padaryti, galite tiksliai sureguliuoti, kaip tikrinamas jūsų svetainės turinys.

- Paieškos variklis talpins robots.txt turinį talpykloje, tačiau paprastai atnaujina talpyklos turinį bent kartą per dieną. Jei pakeisite failą ir norite jį atnaujinti greičiau nei įvyksta, galite pateikti „robots.txt“ URL „Google“ .

Robots.txt vs meta robotai vs x-robotai

Tiek daug robotų! Kuo skiriasi šie trys robotų instrukcijų tipai? Pirmiausia, robots.txt yra tikras tekstinis failas, o meta ir x-robotai yra meta direktyvos . Be to, kokie jie yra iš tikrųjų, visi jie atlieka skirtingas funkcijas. „Robots.txt“ diktuoja svetainės ar katalogo tikrinimo elgseną, o meta ir „x-robotai“ gali diktuoti indeksavimo veiksmus atskirų puslapių (arba puslapio elementų) lygiu.

interneto svetainės robots.txt

Kitos paslaptys apie « interneto svetainės robots.txt » gali būti atskleistos mūsų Facebook grupėje.

Ieškoti pagal:

Internetinės svetainės, Internetinės svetainės puslapius, Interneto svetainės, paieškos sistemos, robots.txt failas, Svetainės puslapio